Estratégias para aprender com o fracasso

30 de agosto de 2016

A sabedoria resultante dos aprendizados do fracasso é incontestável. No entanto, as organizações que fazem isso de forma bem-feita são extremamente raras e isso nada tem a ver com uma falta de comprometimento com a aprendizagem. Em sua maioria, os gestores das empresas que eu pude estudar ao longo dos últimos 20 anos – farmacêuticas, prestadoras de serviços financeiros, designers de produto, telecomunicações, empresas de construção, hospitais, programa de ônibus espaciais da NASA, entre outras – realmente queriam ajudar suas organizações a aprender com os fracassos para terem um desempenho melhor no futuro. Em alguns casos, eles e suas equipes dedicavam muitas horas para realizar avaliações pós-ação, lições aprendidas e etc., mas repetidas vezes eu pude ver que estes esforços não levavam a nenhuma mudança real. O motivo: os gestores estavam pensando sobre o fracasso da forma errada.

A maioria dos executivos com quem conversei acredita que o fracasso é ruim (obviamente). Eles também acreditam que aprender com o fracasso é algo bastante simples: peça às pessoas para refletirem sobre seus erros e as incentive a evita-los no futuro, ou, melhor ainda, designe uma equipe para analisar e elaborar um relatório sobre o que aconteceu e, em seguida, distribua-o pela organização.

Estas crenças amplamente difundidas estão equivocadas. Em primeiro lugar, o fracasso não é algo que é sempre ruim. No mundo empresarial, o fracasso às vezes é ruim, às vezes inevitável e às vezes pode ser até bom. Em segundo lugar, aprender com as falhas organizacionais não é nada simples. As atitudes e atividades imprescindíveis para detectar e analisar as falhas de forma eficaz estão em falta na maioria das empresas, e a necessidade de estratégias de aprendizagem específicas ao contexto é subvalorizada. As organizações precisam de novas e melhores formas para ir além das lições que se mostram superficiais (“Procedimentos não foram seguidos”) ou autopiedosas (“O mercado não estava pronto para o nosso grande novo produto”). Isso significa abandonar velhas crenças culturais e noções estereotipadas de sucesso e abraçar os aprendizados do fracasso. Líderes podem começar tentando compreender a forma como o jogo da culpa pode atrapalhar todo esse processo.

O Jogo da Culpa

O fracasso e a culpa são praticamente inseparáveis na maioria das famílias, organizações e culturas. As crianças aprendem, em algum ponto, que admitir o fracasso significa assumir a culpa. É por este motivo que tão poucas organizações têm investido em uma cultura de segurança psicológica onde as recompensas de se aprender com os fracassos são claras e incentivadoras.

Os executivos que eu entrevistei – que são de organizações que vão desde hospitais a bancos de investimento – admitem: como podem responder de forma construtiva aos fracassos sem incentivar um ambiente onde tudo é válido? Se as pessoas não são culpadas por suas falhas, o que irá garantir que elas tentarão dar o seu melhor?

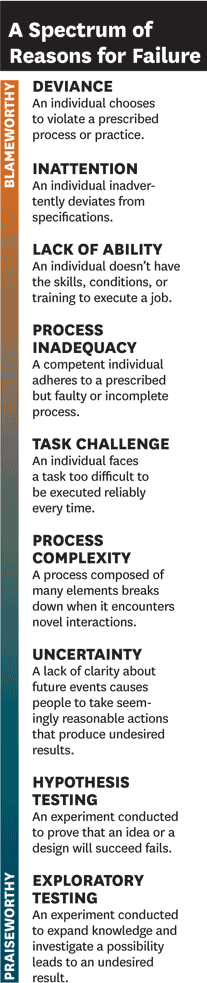

Esta preocupação se baseia em uma falsa dicotomia. Na realidade, uma cultura que faz com que seja seguro admitir e expor uma falha pode – e, em alguns contextos organizacionais, deve – coexistir com padrões de alto desempenho. Para entender o porquê disso, veja a imagem “A Spectrum of Reasons for Failure” (ou, em português, Um Espectro de Razões para o Fracasso), que enumera estas causas, que vão desde um desvio deliberado à uma experimentação inteligente.

Quais dessas causas são culpáveis? O desvio deliberado, em primeiro lugar na lista, obviamente, é culpável. Mas a desatenção talvez não seja. Se a falha resultar de uma falta de esforço, talvez seja culpável. Mas se for resultado do cansaço de um turno excessivamente longo, o gerente que atribuiu este turno é mais culpado do que o empregado. À medida que descemos na lista, torna-se cada vez mais difícil encontrar ações passíveis de culpa. Na verdade, uma falha resultante de uma experimentação inteligente que gere informações valiosas pode ser algo realmente louvável.

Ao pedir para os executivos considerarem este espectro de razões e, em seguida, estimarem quantas das falhas em suas organizações são verdadeiramente passíveis de culpa, suas respostas foram geralmente em torno de números de um dígito, 2% a 5%. Mas ao perguntar quantas destas falhas são tratadas como culpáveis, eles dizem (após uma pausa ou uma risada) 70% a 90%. Lamentavelmente, a consequência disso é que muitas falhas não são notificadas e seus aprendizados são perdidos.

Nem Todos os Fracassos São Criados Igualmente

Uma compreensão sofisticada das causas e contextos dos fracassos ajudará a evitar o jogo da culpa e instituirá uma estratégia eficaz para aprender com os erros. Apesar de existir milhares de coisas que podem dar errado em uma organização, as falhas podem ser classificadas em três grandes categorias: evitáveis, relacionados à complexidade e inteligentes.

Falhas Evitáveis em Operações Previsíveis.

A maioria das falhas nesta categoria pode realmente ser considerada “ruim”. Geralmente envolvem desvios de especificação nos processos bem definidos de alto volume ou em operações de rotina em manufatura e prestação de serviços. Com o suporte e treinamento adequados, é possível que os funcionários sigam esses processos de forma consistente. Quando não o fazem, o desvio, a desatenção ou a falta de capacidade é geralmente a razão. Mas, em tais casos, as causas podem ser prontamente identificadas e soluções desenvolvidas. Fazer checklists (como no recente best-seller do cirurgião de Harvard, Atul Gawande, “The Checklist Manifesto”) pode ser uma solução. Outra é o famoso Sistema de Produção da Toyota, que possibilita a aprendizagem contínua com pequenas falhas (pequenos desvios de processo). Como a maioria dos estudantes de operações bem sabe, um membro da equipe em uma linha de montagem da Toyota, ao se deparar com um problema ou mesmo com um problema em potencial, ele é encorajado a puxar uma corda chamada Andon, que inicia imediatamente um processo de diagnóstico e resolução de problemas. A produção continua normalmente se o problema puder ser resolvido em menos de um minuto. Caso contrário, a produção é interrompida, apesar das perdas consequentes, até que a falha seja compreendida e resolvida.

Falhas Inevitáveis em Sistemas Complexos.

Um grande número de falhas organizacionais tem como motivo a incerteza inerente do trabalho: uma combinação específica de necessidades, pessoas e problemas que nunca ocorreu antes. Pacientes na triagem do pronto socorro de um hospital, reagir às ações do inimigo no campo de batalha e uma start-up de rápido crescimento, são todas estas situações imprevisíveis. E em organizações complexas, como porta-aviões e usinas nucleares, uma falha no sistema é um risco permanente.

Embora as falhas graves possam ser evitadas seguindo melhores práticas de segurança e gestão de risco, incluindo uma análise profunda de qualquer um desses eventos, pequenas falhas no processo são inevitáveis. Considerá-las ruins, não é apenas um mau entendimento de como sistemas complexos funcionam, é contraproducente. Evitar falhas consequentes significa rapidamente identificar e corrigir pequenas falhas. A maioria dos acidentes em hospitais é resultado de uma série de pequenas falhas que passaram despercebidas e que, infelizmente, ocorreram na ordem errada.

Falhas Inteligentes na Fronteira.

Falhas nesta categoria podem ser consideradas “boas”, pois fornecem novos e valiosos conhecimentos que podem ajudar a organização estar à frente da concorrência e assegurar o seu crescimento futuro, razão pela qual o professor de gestão da Universidade Duke, Sim Sitkin, as chamam de falhas inteligentes. Elas ocorrem quando a experimentação é necessária: quando as respostas não são conhecidas com antecedência, pois esta situação específica nunca aconteceu antes e talvez nunca aconteça novamente. Descobrir novos medicamentos, criar um novo modelo de negócio totalmente diferente, conceber um produto inovador e testar as reações dos clientes em um mercado completamente novo são tarefas que exigem falhas inteligentes. “Tentativa e erro” é um termo comum para o tipo de experimentação necessária nesses ambientes, mas é um equívoco, pois a palavra “erro” implica que o resultado não foi “certo”. Na fronteira, o tipo certo de experimentação produz boas falhas rapidamente. Gestores que praticam isso podem evitar as falhas ininteligentes ao realizar experimentos em uma escala maior do que a necessária.

Os líderes da empresa de design de produto IDEO compreenderam esse processo ao lançarem um novo serviço de estratégia de inovação. Ao invés de ajudar os clientes a projetarem novos produtos dentro de suas linhas existentes, o serviço iria ajudá-los a criar novas linhas direcionando-os a novas estratégicas. Sabendo que ainda não havia descoberto uma forma eficaz de fornecer o serviço, a empresa iniciou um pequeno projeto com uma empresa de colchões e não anunciou publicamente o lançamento do novo negócio.

Embora o projeto tenha falhado – o cliente não mudou sua estratégia de produto – a IDEO aprendeu com isso e descobriu o que precisava ser feito de forma diferente. Por exemplo, contratou membros para a equipe com MBAs que poderiam melhor ajudar os clientes a criar novos negócios e integrou à equipe alguns dos gestores dos clientes. Atualmente os serviços para inovação estratégica representam mais de um terço da receita da IDEO.

Tolerar falhas inevitáveis de processos em sistemas complexos e falhas inteligentes nas fronteiras do conhecimento não irá promover a mediocridade. De fato, a tolerância é essencial para qualquer organização que deseja extrair o conhecimento que tais falhas proporcionam. Mas o fracasso é ainda inerentemente emocional. Para fazer com que a organização o aceite, é preciso liderança.

A Construção de uma Cultura de Aprendizagem

Apenas líderes podem criar e reforçar uma cultura que neutraliza o jogo da culpa e faz com que as pessoas se sintam tanto confortáveis, quanto responsáveis por lidar e aprender com os fracassos. Eles devem insistir que suas organizações desenvolvam uma compreensão clara do ocorrido – e não a de “quem fez isso” – quando as coisas derem errado. Isso requer relatar consistentemente as falhas, pequenas e grandes, analisá-las sistematicamente e buscar proativamente oportunidades de experimentação.

Os líderes também devem transmitir a mensagem certa sobre a natureza do trabalho, como lembrar as pessoas de P&D, “Estamos num campo que trabalha com descobertas, quanto mais rápido falharmos, mais rápido teremos resultados”. Eu descobri que os gerentes muitas vezes não compreendem ou apreciam este ponto sutil, mas crucial. Eles também podem abordar o fracasso de uma forma que não é apropriada para o contexto. Por exemplo, controle estatístico de processo, que utiliza análise de dados para avaliar variações injustificadas, não é bom para capturar e corrigir falhas aleatórias invisíveis, tais como erros de software. Também não ajuda no desenvolvimento de novos produtos criativos. Por outro lado, apesar de grandes cientistas intuitivamente aderirem ao slogan da IDEO, “Falhe muitas vezes para alcançar os resultados mais cedo”, isso dificilmente promove o sucesso em uma fábrica.

O slogan “Falhe muitas vezes para alcançar os resultados mais cedo” dificilmente promove o sucesso em uma fábrica.

Muitas vezes, um contexto ou um tipo de trabalho domina a cultura de uma empresa e molda a forma como ela trata o fracasso. Por exemplo, empresas automotivas, com suas operações previsíveis e de alto volume, compreensivelmente, tendem a ver o fracasso como algo que pode e deve ser evitado. Mas a maioria das organizações se envolve em todos os três tipos de trabalho discutidos acima – rotineiro, complexo e de fronteira. Os líderes devem assegurar que a abordagem certa para aprender com o fracasso seja aplicada em cada um dos três. Todas as organizações podem aprender com as falhas através de três atividades essenciais: detecção, análise e experimentação.

Detecção de Falhas

Detectar falhas grandes, caras e dolorosas é fácil. Mas em muitas organizações, qualquer falha que possa ser escondida, será escondida enquanto for improvável que cause danos imediatos ou óbvios. O ponto é trazê-la à tona cedo, antes que o problema cresça e se transforme em um desastre.

Logo após sair da Boeing para tomar as rédeas da Ford, em setembro de 2006, Alan Mulally instituiu um novo sistema para detectar falhas: seus gestores deveriam usar uma sinalização com cores em seus relatórios, verde para bom, amarelo para cautela ou vermelho para problema – uma técnica de gestão comum. De acordo com uma história de 2009 na Fortune, em suas primeiras reuniões, todos os gestores sinalizaram suas operações como verde para a frustração de Mulally. Os lembrando de que a empresa havia perdido bilhões de dólares no ano anterior, ele disse, “Não há nada que não esteja indo bem?”. Após um relatório sobre um grande defeito de um produto que provavelmente iria atrasar o lançamento ter sido sinalizado de amarelo, Mulally respondeu ao silêncio que se seguiu na sala de reunião com aplausos. Depois disso, as reuniões semanais estavam cheias de cores.

Essa história ilustra um problema generalizado e fundamental: embora existam muitos métodos para trazer à tona falhas atuais e pendentes, eles são subutilizados. A Gestão da Qualidade e solicitar feedback dos clientes são técnicas bem conhecidas por trazer à tona falhas em operações de rotina. As práticas de Organizações de Alta Confiabilidade (OAC) ajudam a prevenir falhas catastróficas em sistemas complexos, como os de usinas de energia nuclear, através de uma detecção precoce. A Electricité de France, que opera 58 usinas nucleares, tem sido um exemplo nesta questão: ela vai além dos requisitos regulamentares e religiosamente monitora cada planta procurando até os eventos que sejam apenas um pouco fora do comum, investiga imediatamente qualquer coisa que surja e informa todas as suas outras plantas sobre quaisquer anomalias.

Tais métodos não são empregados de forma mais ampla, pois todos os mensageiros – mesmo os executivos mais experientes – permanecem relutantes em transmitir más notícias para seus chefes e colegas. Um executivo sênior que conheço de uma grande empresa de produtos de consumo possuía sérias preocupações sobre uma aquisição que já estava em andamento quando se juntou à equipe de gestão. Mas, consciente de seu status de recém-chegado, ele permaneceu em silêncio durante as reuniões na qual todos os outros executivos pareciam entusiasmados com o projeto. Meses depois, quando a aquisição havia falhado, a equipe se reuniu para rever o que tinha acontecido. Com a ajuda de um consultor, cada executivo considerou o que ele ou ela fez para contribuir para o fracasso do projeto. O recém-chegado pediu desculpas abertamente sobre a sua omissão e explicou que o entusiasmo dos outros o fez não querer ser o “estraga festas”.

Ao pesquisar por erros e outras falhas nos hospitais, descobri diferenças substanciais entre as unidades de assistência ao paciente e a disposição dos enfermeiros de falar sobre a questão. Descobriu-se que o comportamento dos gerentes médios – a forma como respondem às falhas e como incentivam a discussão aberta sobre elas, como recebem questionamentos, demonstram humildade e curiosidade – era a causa. Pude ver o mesmo padrão em diversas organizações.

Um caso terrível que exemplifica essa questão, cujo qual estudei por mais de dois anos, é a explosão do ônibus espacial Columbia em 2003 que matou sete astronautas (veja o artigo “Facing Ambiguous Threats” de Michael A. Roberto, Richard M.J. Bohmer e Amy C . Edmondson, HBR novembro 2006). Os gerentes da NASA passaram cerca de duas semanas minimizando a gravidade de um pedaço de espuma do lado esquerdo da parte de fora do ônibus espacial que se quebrou durante seu lançamento. Eles rejeitaram as solicitações dos engenheiros para resolver o problema (o que poderia ter sido feito ao usar um satélite para fotografar o ônibus ou pedir os astronautas para realizarem uma inspeção na área em questão), e a grande falha passou despercebida até as suas consequências fatais 16 dias depois. Ironicamente, uma crença geral, mas sem fundamento, entre os gestores do programa era de que havia pouco a ser feito e isso contribuiu para a incapacidade de detectar a falha. Análises posteriores sugeriram que eles poderiam de fato ter tomado medidas frutíferas, mas, claramente, os líderes não tinham estabelecido a cultura, sistemas e procedimentos necessários.

Um dos desafios é ensinar as pessoas em uma organização quando declarar o fracasso em uma experimentação. A tendência humana de esperar pelo melhor e de tentar evitar o fracasso a todo o custo permanece no caminho, e hierarquias organizacionais a deixam ainda maior. Como resultado, projetos falhos de P&D são frequentemente mantidos por muito mais tempo do é cientificamente racional ou economicamente prudente. É comum jogarmos fora uma boa quantidade de dinheiro em fracassos, rezando para que tiremos um coelho da cartola e tudo se resolva. A intuição pode dizer a engenheiros ou cientistas que um projeto possui falhas fatais, mas a decisão de identifica-la formalmente como tal pode ser adiada por meses.

Novamente, o remédio – o que não necessariamente envolve muito tempo e custo – é reduzir o estigma do fracasso. A empresa farmacêutica Eli Lilly tem feito isso desde o início da década de 1990, promovendo “festas do fracasso” para honrar experimentos científicos inteligentes e de alta qualidade que falharam em alcançar os resultados esperados. As festas não custam muito e redistribuir recursos – especialmente cientistas – para novos projetos mais cedo pode significar uma economia de centenas de milhares de dólares, sem mencionar o aumento do potencial de novas descobertas.

Analisando o Fracasso

Após uma falha ser detectada, é essencial ir além das razões óbvias e superficiais para poder entender suas causas. Isto requer a disciplina – ou, melhor ainda, o entusiasmo – para usar análises sofisticadas para garantir que as lições certas sejam aprendidas e as soluções corretas sejam empregadas. O trabalho dos líderes é ver que as suas organizações não apenas seguem em frente após um fracasso, mas param de se aprofundar no problema e descobrem a sabedoria contida nele.

Por que a análise do fracasso é, muitas vezes, enganosa? Porque examinar nossas falhas em profundidade é emocionalmente desagradável e pode abalar nossa autoestima. Desta forma, a maioria de nós irá tentar acelerar ou evitar a análise do fracasso. Outra razão é que analisar falhas organizacionais exige investigação, franqueza, paciência e uma tolerância para ambiguidade causal. No entanto, gestores normalmente são admirados e recompensados por determinação, eficiência e ação – e não por reflexões profundas. É por este motivo que a cultura certa é tão importante.

O desafio é mais do que emocional, também é cognitivo. Mesmo de forma não intencional, todos somos evidências que suportam nossas crenças existentes ao invés de explicações alternativas. Também tendemos a subestimar a nossa responsabilidade e colocar a culpa (de forma indevida) em fatores externos ou situacionais quando falhamos, mas fazemos o inverso ao avaliar as falhas dos outros – uma armadilha psicológica conhecida como erro fundamental de atribuição.

Minha pesquisa indicou que a análise do fracasso é, muitas vezes, limitada e ineficaz, mesmo em organizações complexas, como hospitais, onde vidas humanas estão em jogo. Poucos hospitais analisam sistematicamente os erros médicos ou falhas de processo para colher os aprendizados. Uma pesquisa recente nos hospitais da Carolina do Norte, publicada em novembro de 2010 no New England Journal of Medicine, constatou que, apesar de 12 anos de um aumento constante de conscientização de que erros médicos resultam em milhares de mortes todos os anos, os hospitais não se tornaram mais seguros.

Felizmente, existem exceções, que continuam a dar esperança de que a aprendizagem organizacional é possível. No Intermountain Healthcare, um sistema de 23 hospitais que servem os estados americanos de Utah e Idaho, as irregularidades dos médicos em relação aos protocolos que devem ser seguidos são rotineiramente analisadas para encontrar oportunidades de melhoraria destes protocolos. Permitir irregularidades e compartilhar os dados demonstrando que essa prática realmente produz melhores resultados, incentiva os médicos a abraçarem este programa (veja “Fixing Health Care on the Front Lines” de Richard M. J. Bohmer, HBR de abril de 2010).

Motivar as pessoas a ir além das razões de primeira ordem (“procedimentos não foram seguidos”) para compreender as razões de segunda e terceira ordem pode ser um grande desafio. Uma maneira de se fazer isso é usar equipes interdisciplinares com diversas habilidades e perspectivas. Falhas complexas, em particular, são resultados de vários eventos que ocorreram em diferentes departamentos, disciplinas ou em diferentes níveis da organização. Entender o que ocorreu e como evitar que ocorra novamente requer uma discussão e análise detalhada em equipe.

Uma equipe de especialistas (físicos, engenheiros, especialistas em aviação, líderes navais), e até mesmo astronautas, dedicaram meses para analisar o desastre com o ônibus espacial Columbia. Eles não somente estabeleceram a causa de primeira ordem – um pedaço de espuma havia atingido a ponta da aeronave durante seu lançamento –, mas também as causas de segunda ordem: uma hierarquia rígida e uma cultura obcecada por cronogramas da NASA criaram dificuldades para os engenheiros falarem sobre qualquer coisa que não fossem preocupações mais sólidas.

Incentivando a Experimentação

A terceira atividade crítica para uma aprendizagem eficaz é produzir fracassos estrategicamente, nos lugares certos e nos momentos certos através da experimentação sistemática. Pesquisadores científicos sabem que, embora as experiências ocasionalmente resultem em um sucesso espetacular, uma grande porcentagem delas (70% ou mais em algumas áreas) falhará. O que faz com que essas pessoas saiam de suas camas de manhã? Em primeiro lugar, elas sabem que o fracasso não é uma opção em seu trabalho, é parte necessária para estar na vanguarda da descoberta científica. Em segundo lugar, muito mais do que a maioria de nós, eles entendem que cada fracasso possui informações valiosas e estão ansiosos para fracassarem antes que seus concorrentes o façam.

Em contraste, gerentes encarregados de liderar um projeto para um novo produto ou serviço – um exemplo clássico de experimentação nos negócios – normalmente fazem o que podem para se certificar de que o piloto do projeto seja perfeito desde o início. Ironicamente, essa fome de sucesso pode inibir os resultados positivos do lançamento oficial posteriormente. Por diversas vezes, gestores responsáveis por pilotos projetam condições ideais ao invés de condições representativas. Assim, o piloto não produz conhecimento sobre o que não vai funcionar.

Por diversas vezes, projetos-piloto são conduzidos sob condições ideais ao invés de condições representativas. Assim, o piloto não produz conhecimento sobre o que não vai funcionar.

Nos primeiros dias da tecnologia DSL, uma grande empresa de telecomunicações – que chamarei apenas de “Telco” – fez um lançamento em grande escala de sua tecnologia de alta velocidade para consumidores em um grande mercado urbano. Foi um desastre absoluto de serviço ao cliente. A empresa perdeu 75% de seus contratos e se viu diante de uma acumulação de 12.000 pedidos atrasados. Os clientes estavam frustrados e indignados, e os funcionários do serviço ao cliente não conseguiam responder a todas as chamadas. A moral dos empregados estava danificada. Como isso pôde acontecer a uma empresa líder com altos índices de satisfação e uma marca que era reconhecida por sua excelência?

Um pequeno piloto realizado em uma área suburbana e que foi extremamente bem sucedido havia entusiasmado os executivos da Telco com uma confiança um tanto quanto equivocada. O problema era que o piloto não se assemelhava às condições reais: foi composto por funcionários do serviço ao cliente especializados e extraordinariamente gentis, e ocorreu em uma comunidade de clientes educados e com experiência em tecnologia. Mas a DSL era uma tecnologia totalmente nova e, ao contrário da telefonia tradicional, interagia com uma alta variabilidade de computadores domésticos e de habilidades técnicas dos clientes. Isso acrescentou complexidade e imprevisibilidade ao desafio.

Seria mais útil um piloto que fosse testado com um suporte limitado à tecnologia, clientes menos sofisticados e computadores mais antigos, de forma que seria possível descobrir tudo o que poderia dar errado, ao invés de provar que, na melhor das hipóteses, tudo iria dar certo. É claro que para isso seria necessário que os gestores responsáveis entendessem que não seriam recompensados pelo sucesso, mas, sim, pela produção de fracassos inteligentes o mais rápido possível.

Resumindo, as organizações excepcionais são aquelas que vão além da detecção e análise de falhas e tentam gerar mais falhas inteligentes com o propósito de aprendizagem e inovação. A questão nada tem a ver com os gestores dessas organizações gostarem de falhas, mas eles as reconhecem como um subproduto necessário da experimentação. Eles também percebem que não é necessário realizar experimentações dramáticas com grandes orçamentos. Muitas vezes um pequeno piloto, um ensaio de uma nova técnica ou uma simulação é o suficiente.

A coragem para enfrentar nossas próprias imperfeições e as dos outros é crucial para resolver a aparente contradição de não querer desencorajar o relato de problemas e nem de criar um ambiente em que tudo é permitido. Isso significa que os gestores devem pedir aos funcionários que sejam corajosos para falar sobre a questão e não devem responder a eles expressando raiva ou desaprovação do que pode parecer, à primeira vista, ser incompetência. Mais frequentemente do que imaginamos, sistemas complexos estão por trás de falhas organizacionais, e suas lições e oportunidades de melhoria são perdidas quando a conversa aberta não é incentivada.

Gerentes experientes compreendem os riscos de uma resistência desenfreada. Eles sabem que a capacidade de descobrir e resolver problemas depende da capacidade de aprender sobre eles. Mas a maioria dos gestores que encontrei através da minha pesquisa e de meus trabalhos de consultoria e ensino é muito mais sensível a um risco diferente, de forma que uma resposta compreensiva às falhas simplesmente irá criar um ambiente de trabalho relaxado em que os erros se multiplicam.

Esta preocupação comum deve ser substituída por um novo paradigma, um que reconheça a inevitabilidade do fracasso nas organizações complexas de hoje. Um paradigma que detecte, corrija e aprenda com os erros antes que seus concorrentes para alcançar o sucesso. Um modelo que se baseia no jogo da culpa, definitivamente, não terá os mesmos resultados.

Artigo traduzido: https://hbr.org/2011/04/strategies-for-learning-from-failure?referral=02532&cm_vc=rr_home_page.for_you]]>